مدلهای زبانی بزرگ، نوعی از جدیدترین فناوریهای هوش مصنوعی هستند که میتوانند زبان انسان را درک کنند و به شیوهای کاملاً قابل فهم پاسخ دهند. نقطه شروع ظهور این مدلها به سال ۲۰۱۷ برمیگردد؛ زمانی که مقاله معروف «Attention Is All You Need» منتشر شد و معماری ترنسفورمر را معرفی کرد.

از همان زمان تا امروز، یعنی حدود 8-9 سال، این فناوری با سرعتی باورنکردنی پیشرفت کرده و اکنون مدلهایی در دسترس عموم قرار دارند که میتوانند به زبانهایی مانند فارسی، انگلیسی و بسیاری زبانهای دیگر صحبت کنند و حتی استدلال انجام دهند.

همراه ما باشید تا بیشتر با مدل زبانی بزرگ (LLM) آشنا شوید.

مدل زبانی بزرگ (LLM) چیست؟

مدل زبانی بزرگ یا Large Language Model نسل جدید سیستمهای هوش مصنوعی است که با استفاده از یادگیری عمیق (Deep Learning) و مجموعهدادههای عظیم متنی آموزش داده میشود تا بتواند زبان انسان را تحلیل و تولید کند.

این مدلها قادرند وظایف بسیار متنوعی انجام دهند، مانند:

- تولید محتوا

- ترجمه

- خلاصهسازی

- تحلیل احساسات

- کدنویسی

- پاسخ به پرسشهای پیچیده

امروزه LLMها در مرکز سرویسهای هوش مصنوعی معروف مانند ChatGPT، Google Gemini، Claude و مدلهای Llama قرار دارند.

چگونه مدلهای زبانی بزرگ کار میکنند؟

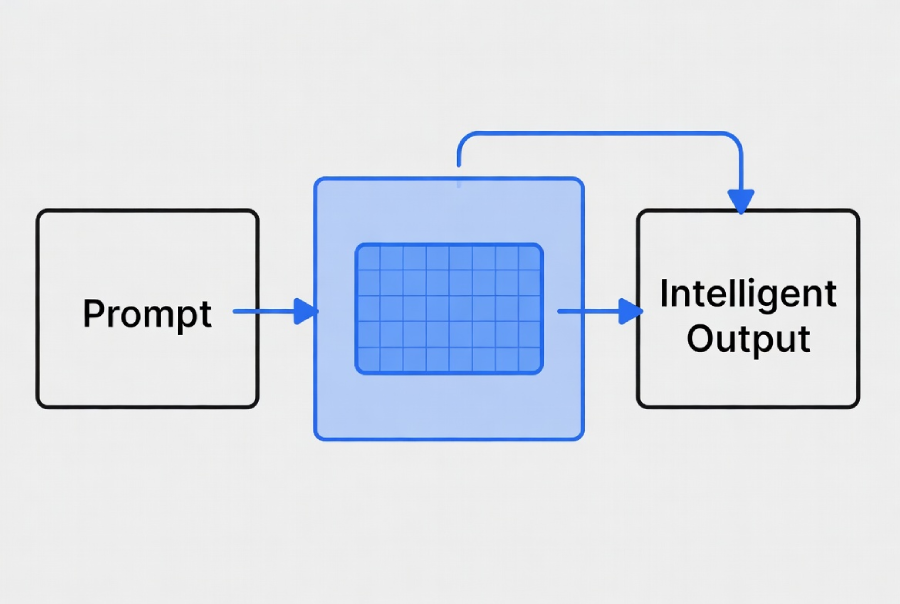

LLMها با تحلیل ارتباط بین کلمات و جملات، الگوهای زبان را یاد میگیرند. وقتی یک متن ورودی دریافت میکنند (مثلاً یک پرسش)، آن را به توکنهایی تبدیل کرده و با محاسبه احتمالات، محتملترین توکن بعدی را تولید میکنند.

عملکرد مدلهای زبانی بزرگ بر پایه معماری ترنسفورمر است. این معماری به مدل اجازه میدهد تمام بخشهای یک جمله را همزمان ببیند و بفهمد کدام کلمات به یکدیگر مرتبط هستند. بهجای اینکه متن را کلمهبهکلمه و پشتسرهم بخواند، کل جمله را «یکجا» پردازش میکند و ارتباطهای مهم را استخراج میکند.

فرآیند کلی کار LLM:

- دریافت ورودی (Prompt)

- تبدیل متن به توکنها

- تحلیل روابط معنایی و نحوی

- محاسبه احتمالها

- تولید خروجی بهصورت مرحلهای

معماری ترنسفورمر و نقش آن در پردازش زبان طبیعی

معماری Transformer نقطه انقلاب در پردازش زبان طبیعی بود. پیش از آن مدلها مجبور بودند متن را به صورت خطی و پشتسرهم پردازش کنند؛ اما ترنسفورمر این محدودیت را از بین برد. یعنی چه؟

یعنی ترنسفورمر توانست همه کلمات یک جمله را بهطور همزمان بررسی کند و بفهمد هر کلمه با کدام بخشهای دیگر مرتبط است. این توانایی، مدل را بسیار هوشمندتر کرد و باعث شد مفاهیم پیچیده زبانی بهتر درک شوند.

ویژگیهای اصلی ترنسفورمر به شرح زیر هستند:

- تحلیل همزمان همه کلمات یک جمله

- درک وابستگیهای کوتاه و بلندمدت

- پردازش سریعتر و دقیقتر نسبت به RNN و LSTM

- پایه اصلی مدلهایی مانند GPT، BERT، Gemini و Llama

اجزای اصلی LLM: انکودر، دیکودر و مکانیزم توجه

ترنسفورمر از بلوکهای اصلی زیر تشکیل شده است:

۱. انکودر (Encoder)

انکودر مانند مغز تحلیلگر مدل عمل میکند. وقتی یک متن وارد مدل میشود، انکودر تمام کلمات را بررسی میکند، معنی آنها را استخراج میکند و تعیین میکند که هر کلمه با چه قسمتهایی از متن مرتبط است.

مدلهایی مانند BERT فقط از انکودر استفاده میکنند، زیرا هدف اصلیشان «درک زبان» است نه تولید آن.

۲. دیکودر (Decoder)

دیکودر بخش «مولد» مدل است. یعنی مرحلهبهمرحله متن جدید مینویسد، پیشبینی میکند و جمله را تکمیل میکند. مدلهایی مثل GPT فقط دیکودر دارند و به همین دلیل در تولید متن بسیار قوی هستند.

۳. مکانیزم توجه (Attention Mechanism)

مکانیزم توجه مهمترین بخش این معماری است. چرا که توجه مشخص میکند مدل باید به کدام کلمات بیشتر دقت کند.

مثلاً اگر در جمله «علی کتاب را به مریم داد» سؤال شود «چه کسی کتاب را داد؟»، مدل باید روی «علی» تمرکز کند؛ این کار را مکانیزم توجه انجام میدهد.

مراحل آموزش LLMها: پیشآموزی و تنظیم دقیق

آموزش مدلهای زبانی در دو مرحله اصلی انجام میشود:

۱. پیشآموزی (Pretraining)

مدل روی حجمی عظیم از دادهها مانند:

- کتابها

- صفحات وب

- مقالات علمی

- کدهای برنامهنویسی

آموزش میبیند و مفاهیم عمومی زبان را یاد میگیرد.

۲. تنظیم دقیق (Fine-Tuning)

در این مرحله مدل روی دادههای کوچکتر اما تخصصیتر آموزش میبیند، مانند:

- پزشکی

- حقوق

- مالی

- کدنویسی

ریزتنظیمها کمک میکنند مدل از یک «هوش عمومی» به یک «کارشناس تخصصی» تبدیل شود. مثل:

- ریزتنظیم نظارتشده (Supervised Fine-Tuning)

- یادگیری چندجرعهای (Few-shot Learning)

- ریزتنظیم حوزهمحور (Domain-specific FT)

مقایسه ریزتنظیم و RAG

ریزتنظیم و RAG هر دو روشهایی برای هوشمندتر کردن LLMها هستند، اما رویکرد کاملاً متفاوتی دارند. ریزتنظیم مدل را «به متخصص تبدیل میکند»، در حالی که RAG کمک میکند مدل به اطلاعات جدید و واقعی دسترسی داشته باشد.

|

ویژگی |

Fine-Tuning |

RAG |

|

هزینه |

بالا |

متوسط |

|

نیاز به داده |

داده برچسبدار |

اسناد واقعی |

|

بهروز بودن اطلاعات |

کم |

بسیار بالا |

|

موارد استفاده |

وظایف تخصصی |

پرسشهای دانشمحور |

مدلهای چندوجهی (Multimodal)

یک نوع از LLMها، مدلهای چندوجهی هستند؛ یعنی مدلهایی که فقط متن را نمیفهمند، بلکه قادرند تصویر، صدا، ویدئو و حتی دادههای حسگرها را هم تحلیل کنند. این مدلها چندین نوع ورودی را همزمان پردازش کرده و خروجی ترکیبی ارائه میدهند؛ مثلاً هم توضیح مینویسند، هم تصویر را تحلیل میکنند.

مثالها:

- GPT-4o و GPT-5.1 (چندوجهی کامل)

- Google Gemini

- Claude 3.5 Sonnet Vision

کاربردها:

- تحلیل تصاویر

- تبدیل گفتار به متن

- تعامل صوتی

- درک اسناد چندلایه (تصویر + متن)

کاربردهای مدلهای زبانی بزرگ چیست؟

LLMها تقریباً در تمام صنایع قابل استفاده هستند.

کاربردهای عمومی:

- تولید محتوا

- ترجمه

- خلاصهسازی

- تولید کد

- تحلیل احساسات

- چتباتها و دستیاران هوشمند

کاربرد در صنایع مختلف:

- سلامت: تحلیل متون پزشکی، کمک به تشخیص

- مالی: تشخیص تقلب، تحلیل گزارشها

- حقوق: بررسی قراردادها و اسناد

- بازاریابی: تولید محتوای هدفمند

- آموزش: پاسخگویی هوشمند به دانشآموزان

مزایا LLMها چیست؟

همانطور که تا اینجا مشاهده کردید، LLMها تأثیر عظیمی بر صنعت فناوری، تولید محتوا، آموزش و حتی کسبوکارها گذاشتهاند. دلیل آن هم ویژگیهای خاصی است که این مدلها را از سیستمهای قبلی متمایز میکند.

برای مثال یکی از مهمترین مزایا انعطافپذیری فوقالعاده آنهاست. یک مدل واحد میتواند دهها کار مختلف مانند ترجمه، خلاصهسازی، پاسخگویی، تولید محتوا، تحلیل دادههای متنی و حتی کدنویسی را انجام دهد و همین موضوع باعث صرفهجویی جدی در زمان و هزینه میشود.

دیگر مزایای مهم LLMها:

- پشتیبانی از حجم کار بالا

- جایگزینی کارهای تکراری

- در دسترس قرار دادن مهارتهای تخصصی

- یادگیری تطبیقی

- یادگیری سریع از مثالها

چالشها LLMها چیست؟

مدلهای زبانی بزرگ تکنولوژی فوقالعاده قدرتمندی هستند، اما چون هنوز نسبتاً نوظهورند، نقصهای خود را دارند. این چالشها میتوانند هم بر کیفیت خروجی مدل تأثیر بگذارند و هم بر نحوه استفاده ایمن از آن.

در این بخش مهمترین چالشهای LLMها را بررسی کردهایم:

- توهم (Hallucination): تولید اطلاعات غلط اما قانعکننده

- سوگیری (Bias): بازتولید سوگیریهای دادههای آموزشی

- شفافیت پایین: مانند “جعبه سیاه”

- هزینه بالا: نیاز به منابع محاسباتی سنگین

- مسائل اخلاقی: خطر انتشار اطلاعات خصوصی

- فراموشی فاجعهبار: از دست دادن دانش قبلی هنگام ریزتنظیم

انواع مدلهای زبانی بزرگ و نمونههای معروف

در آخرین قسمت این مطلب مشهورترین LLMهای جهان را معرفی کردهایم:

|

مدل |

شرکت |

توضیح |

|

GPT سری |

OpenAI |

بهترین مدلهای مولد متن |

|

Google Gemini |

گوگل |

چندوجهی، مناسب تحلیل تصویر |

|

Claude |

Anthropic |

تمرکز بر ایمنی پاسخها |

|

Llama سری |

Meta |

متنباز و محبوب توسعهدهندگان |

|

BERT |

ویژه درک زبان و جستجو |

جمعبندی: آینده مدلهای زبانی بزرگ

LLMها میتوانند در آینده بستر پیشرفتهای بسیار بزرگتری در هوش مصنوعی باشند؛ پیشرفتهایی که اگر همین حالا بخواهیم تصورشان کنیم شامل دستیارهای هوشمند واقعی، ترجمههای بدون خطا، پردازش کامل اسناد حقوقی، تولید محتوای چندوجهی خودکار و حتی نزدیک شدن به مفهوم «هوش مصنوعی عمومی» است.

حالا که این فناوری با سرعت زیاد در حال رشد است، بهتر است کسبوکارها و کاربران یاد بگیرند چگونه از آن استفاده کنند. چه برای افزایش بهرهوری، چه برای کاهش هزینهها و چه برای ساخت ابزارهای هوشمند جدید.

سؤالات متداول (FAQ)

۱. آیا مدلهای زبانی بزرگ همیشه دقیق هستند؟

خیر. امکان تولید محتوای غلط یا ناقص وجود دارد (توهم).

۲. تفاوت LLM با یک چتبات ساده چیست؟

LLM هوش مستقلی برای تولید زبان دارد؛ ولی چتباتهای کلاسیک بر اساس قانونهای ثابت عمل میکنند.

۳. آیا LLMها جایگزین انسان خواهند شد؟

نه؛ اما ابزارهایی قدرتمند برای افزایش بهرهوری هستند.

۴. آیا میتوان یک LLM اختصاصی برای شرکت ایجاد کرد؟

بله. با استفاده از Fine-Tuning یا RAG میتوان یک مدل کاملاً شخصیسازیشده ساخت.

۵. آیا استفاده از LLMها نیاز به مهارت برنامهنویسی دارد؟

نه. اکثر ابزارهای LLM از طریق رابطهای ساده قابل استفادهاند.