در جهانی که ویدیوها، بخش اصلی روایتهای خبری و اجتماعی ما شدهاند، ظهور دیپفیک همهچیز را زیر سؤال برده است. حالا دیگر دیدن کافی نیست. ممکن است آنچه میبینیم واقعیت نباشد، بلکه حاصل الگوریتمهایی باشد که برای فریب چشم انسان طراحی شدهاند. اما دیپفیک چیست و چطور تا این اندازه واقعی و خطرناک به نظر میرسد؟

دیپفیک چیست؟

دیپفیک (Deepfake) ترکیبی از دو واژه Deep Learning (یادگیری عمیق) و Fake (جعل) است.

یعنی یک فناوری بر پایه هوش مصنوعی که میتواند ویدئوهای جعلی ولی کاملا واقعی از شخصیتهای مختلف تولید کند که با واقعیت مو نمیزند!

الگوریتمهای یادگیری ماشین با تحلیل صدها ساعت ویدیو و هزاران تصویر از چهرهی یک فرد، میتوانند حرکات چهره، لحن صدا و حتی سبک گفتار او را تقلید کنند. نتیجهاش هم محتوایی کاملاً جعلی، اما بهطرز ترسناکی واقعی میشود.

چطور میشود چهره و صدا را اینقدر واقعی جعل کرد؟

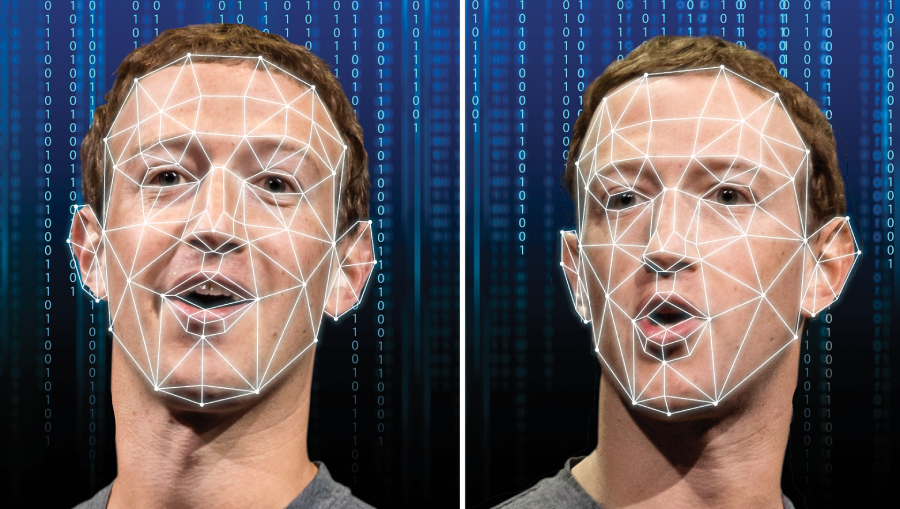

تولید دیپفیک بر پایهی شبکههای مولد تخاصمی (GANs) است. این شبکه شامل دو بخش است:

- مولد (Generator): دادههای آموزشی را تحلیل کرده و محتوای جعلی اولیه را میسازد.

- متمایزکننده (Discriminator): با مقایسهی خروجی با نمونههای واقعی، خطاها را شناسایی و مولد را وادار به اصلاح میکند.

فناوریهای اصلی که در این حوزه به کار میروند، در جدول زیر معرفی شدهاند:

|

فناوری |

کاربرد |

|

شبکههای عصبی کانولوشنی (CNN) |

تحلیل چهره و حرکت تصویر |

|

پردازش زبان طبیعی (NLP) |

تقلید لحن، گفتار و مکثهای طبیعی |

|

یادگیری انتقالی (Transfer Learning) |

انتقال ویژگیهای چهره از یک فرد به دیگری |

از سرگرمی تا سوءاستفاده؛ دیپفیک کجاها استفاده میشود؟

با مطالعه تعریف دیپفیک، ذهنمان سریع به عواقب منفیاش فکر میکند و این که دیگر نمیتوانیم حتی به چشمان خود هم اعتماد کرد؛ ولی مثل هر فناوری دیگر، هم میتواند فرصتساز باشد و هم تهدیدآفرین.

کاربردهای مثبت این فناوری را در ادامه فهرست کردهایم:

- صنعت سرگرمی:

بازسازی چهرهی بازیگران در فیلمها (مانند جوانسازی “رابرت دنیرو” در Irishman).

- آموزش و تاریخ:

بازسازی شخصیتهای تاریخی برای تجربهی آموزشی واقعگرایانه.

- پزشکی:

کمک به بیمارانی که توان گفتار خود را از دست دادهاند تا دوباره با صدای خود حرف بزنند.

- تبلیغات هوشمند:

تولید پیامهای شخصیسازیشده برای مشتریان بدون نیاز به حضور فیزیکی بازیگر.

اما روی تاریک ماجرا…

- اخاذی و باجگیری: ساخت ویدیوهای جعلی برای تخریب اعتبار یا تهدید افراد.

- سوءاستفادههای جنسی: طبق تحقیقات Deeptrace، بیش از ۹۰٪ دیپفیکهای اولیه در دستهی محتوای غیراخلاقی بودهاند.

- تقلب مالی: جعل صدای مدیران برای صدور دستور انتقال وجه (مانند پروندهی ۳۹ میلیون دلاری هنگکنگ در ۲۰۲۴).

- انتشار اخبار جعلی: دستکاری ویدیوهای سیاسی و تأثیرگذاری بر انتخابات.

اعتماد از دست رفته؛ چرا باید نگران باشیم؟

مشکل اصلی دیپفیک فرسایش اعتماد عمومی است. وقتی دیگر نمیدانیم چه چیزی واقعی است، بنیان ارتباطات انسانی و رسانهای فرو میریزد.

با توسعه یافتن هر چه بیشتر این تکنولوژی حتی ویدیوهای واقعی هم زیر سؤال میروند و اینجاست که کاربران اینترنت دیگر هیچ چیز را باور نمیکنند. همچنین افراد سودجو امکان این را پیدا میکنند که با ساخت این ویدئوهای جعلی از دیگران اخاذی کنند و آنها را مورد سو استفاده روانی قرار دهند.

ولی ترسناکتر از همه این موارد این است که حالا هر فردی میتواند ادعا کند “ویدیوی واقعی من جعلی است“.

چند نمونه واقعی که دنیا را شوکه کردند

تا همین سال 2025 که تکنولوژی دیپفیک هنوز به قدر کافی پیشرفته نشده، کلاهبرداریهایی در سطح بینالمللی صورت گرفته و همچنین چهره برخی سلبریتیهای معروف هم خدشهدار شده.

|

سال |

رویداد |

توضیح |

|

۲۰۲۴ |

جعل صدای جو بایدن |

فایل صوتی جعلی از رئیسجمهور آمریکا دربارهی امنیت ملی، باعث ایجاد بحران خبری شد. |

|

۲۰۲۴ |

تقلب مالی هنگکنگ |

کارمند مالی فریب تماس ویدیویی جعلی با چهرهی مدیر خود را خورد و ۳۹ میلیون دلار انتقال داد. |

|

۲۰۲۴ |

دیپفیک تیلور سوئیفت |

انتشار تصاویر مستهجن جعلی باعث موجی از اعتراض در شبکههای اجتماعی شد. |

|

۲۰۱۵–۲۰۱۷ |

بازسازی پل واکر |

استفاده از دیپفیک برای تکمیل نقش بازیگر در فیلم Fast & Furious 7. |

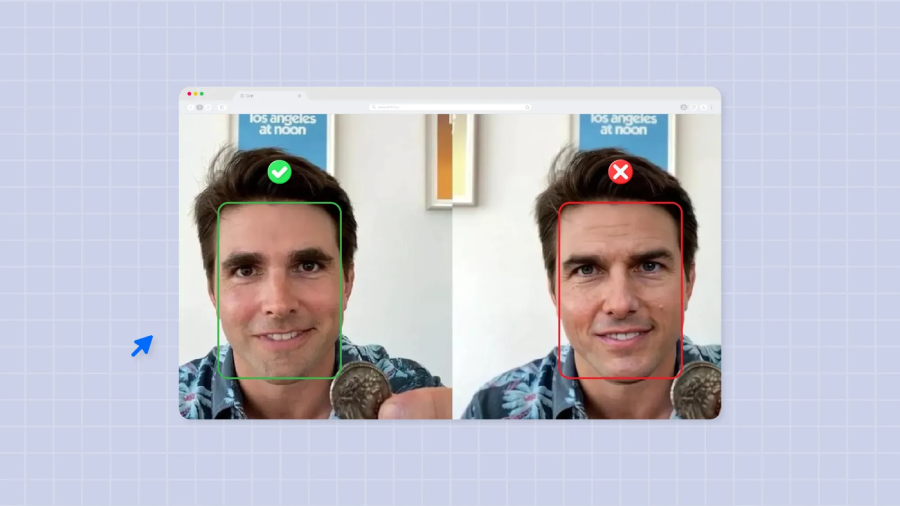

چطور بفهمیم یک ویدیو جعلی است؟

شاید فناوری جعل پیشرفته شده باشد، اما هنوز نشانههایی وجود دارد که میتوان با دقت آنها را دید.

- به چشمها دقت کنید: در بسیاری از دیپفیکها، پلکزدن غیرطبیعی یا نگاه ثابت وجود دارد.

- هماهنگی لب و صدا: لبها دقیقاً با گفتار هماهنگ نیستند.

- نور و سایه: سایهها در چهره با محیط مطابقت ندارند.

- حرکات بدن: گاهی حرکات نرم و پیوسته نیست و به شکل رباتگونه دیده میشود.

- منبع را بررسی کنید: ویدیو را از چند منبع معتبر دیگر بررسی کنید.

- از ابزارهای تشخیص استفاده کنید: ابزارهایی مانند Microsoft Video Authenticator یا Deepware Scanner میتوانند احتمال جعلی بودن را بسنجند.

قانون چه میگوید و ما چه باید بکنیم؟

قوانین در بسیاری از کشورها هنوز از سرعت رشد فناوری دیپفیک عقب ماندهاند، اما تلاشهایی برای تنظیم مقررات آغاز شده است. در برخی ایالتهای آمریکا مانند کالیفرنیا، تولید یا انتشار دیپفیکهای سیاسی یا مستهجن بدون رضایت فرد ممنوع است.

ویرجینیا انتشار محتوای جعلی غیراخلاقی را جرمانگاری کرده و در تگزاس نیز استفاده از دیپفیک برای تأثیرگذاری بر انتخابات غیرقانونی است. ولی هنوز قانون جهانی یا حتی فدرالی جامع در این زمینه وجود ندارد و کشورها در حال تدوین چارچوبهای اخلاقی و حقوقی هستند. در سطح فردی و اجتماعی، اقداماتی که میتوانیم انجام دهیم را در ادامه توضیح دادهایم.

اقدامات ضروری برای کاربران و جامعه

اولین اقدامی که در این زمان بحرانی باید انجام دهیم، آموزش سواد رسانهای است؛ یعنی یاد بگیریم هر ویدیو یا صدایی را بیچونوچرا باور نکنیم. کاربران باید بتوانند بین واقعیت و محتوای دستکاریشده تمایز بگذارند، منبع را بررسی کنند و پیش از بازنشر، از صحت اطلاعات مطمئن شوند.

در گام بعد استفاده از احراز هویت چندعاملی برای حسابهای شخصی و مالی اهمیت بالایی دارد تا قربانی جعل صدا یا تصویر نشویم. علاوه بر کاربران، شرکتهای بزرگ فناوری نیز وظیفه دارند روی ابزارهای تشخیص محتوای جعلی سرمایهگذاری کنند. توسعه الگوریتمهای تشخیص تصویر و صوت مبتنی بر یادگیری عمیق میتواند جلوی انتشار بسیاری از دیپفیکهای مخرب را بگیرد.

همچنین رسانههای اجتماعی باید مسئولیتپذیرتر عمل کنند؛ یعنی ویدیوهای مشکوک را برچسبگذاری کنند، امکان گزارش سریع محتوا را فراهم آورند و در همکاری با نهادهای ناظر، سیستمهای تأیید اصالت محتوا را گسترش دهند.

آیندهای پر از تصویر و تردید؛ بعد از این چه میشود؟

در آینده، مرز بین “واقعی” و “جعلی” بیش از هر زمان دیگری محو خواهد شد.

- هایپررئالیسم: جعلها بهقدری دقیق میشوند که حتی متخصصان هم فریب میخورند.

- فناوریهای متقابل: همانقدر که دیپفیک پیشرفت میکند، ابزارهای تشخیص هم پیشرفتهتر میشوند.

- دسترسی آسان: ساخت دیپفیک ممکن است با تنها یک عکس انجام شود.

یک قدم عقب، یک نگاه عمیق؛ واقعیت هنوز ارزش جنگیدن دارد

در دنیایی که حتی واقعیتها میتوانند ساختگی باشند، شاید بزرگترین مسئولیت ما بازتعریف “اعتماد” باشد. به نظر میرسد در آینده، اعتماد کردن به ویدیوها بهمراتب دشوارتر شود؛ درست مثل دوران اولیهی فوتوشاپ که مردم در ابتدا فریب تصاویر دستکاریشده را میخوردند، اما بعدها چنان چشمشان تربیت شد که از فاصلهای دور، تصویر جعلی را تشخیص میدادند.

شاید همین اتفاق برای ویدیوها هم بیفتد و پس از مدتی، حساسیت ما نسبت به جعلیات کاهش یابد. شاید هم جامعه از کنار این پدیده بیتفاوت عبور کند. اما یک چیز قطعی است: ما برای دیدن واقعیتها در آینده، به مسیر تازهای از راستیآزمایی و درک رسانهای نیاز خواهیم داشت؛ مسیری که در آن فناوری و آگاهی دست در دست هم، حقیقت را از میان انبوه دروغهای دیجیتال بیرون بکشند.

سوالات متداول (FAQ)

۱. دیپفیک فقط ویدیو است یا شامل صدا هم میشود؟

خیر، شامل هر نوع رسانه دیجیتال از جمله صوت، تصویر و ویدیو است.

۲. آیا نرمافزارهای رایگان برای ساخت دیپفیک وجود دارند؟

بله، ابزارهایی مثل DeepFaceLab یا Reface این امکان را فراهم میکنند، اما استفاده غیراخلاقی از آنها جرم محسوب میشود.

۳. آیا میتوان با هوش مصنوعی جعلیها را تشخیص داد؟

بله، ابزارهایی مانند Deepware یا Sensity AI با بررسی فریمبهفریم و تحلیل دادههای بصری، احتمال جعلی بودن را تشخیص میدهند.